前処理なくして分析なし!データサイエンティストが語る失敗談とAI時代のリアル

先日、当社代表 菅の著書『Pythonではじめる データ分析のための前処理入門』(講談社)の出版を記念して、トークイベント「データ分析するなら前処理語らナイト」を開催いたしました。

当日は著者である菅 由紀子(株式会社Rejoui)をはじめ、バーチャルデータサイエンティスト「アイシア=ソリッド」のマスターこと杉山聡さん(株式会社アトラエ)、丸谷優太さん(AKKODiSコンサルティング株式会社)の3名が登壇。いずれもデータサイエンティスト協会スキル定義委員としても活躍しており、現場のリアルな視点から、前処理の奥深さと面白さに迫るセッションとなりました。イベントの様子をお届けします。

前処理の現場から:リアルトークセッション

◆ 失敗から学ぶ、前処理のインパクト

前半では、登壇者それぞれが実務で経験した「前処理の失敗談」を共有。見落としがそのまま分析結果や施策に響くという、前処理の重要性が浮き彫りになりました。

「前処理の失敗談、教えてください!」

キャリア初期に経験した前処理の失敗のひとつとして杉山さんが語ってくれたのは、回帰分析の符号ミスにまつわる実務エピソードです。

当時、売上に関するKPIを上げるには「この変数を増やすべきだ」と分析結果に基づいて提案したものの、後に前処理のミスに気づき、再分析した結果はまさかの真逆──「むしろ減らした方が良い」という結論だったそうです。

普通なら大きな問題になりかねない状況でしたが、幸いにも施策自体はもともとの仮説や現場の流れに沿って進んでいたため、結果としては事なきを得ました。とはいえ杉山さんにとってはこの経験が大きな教訓になったといいます。

「一つのミスで分析の方向性を180度変えてしまう。前処理って命かかってるんだ、と痛感した」とのこと。それ以来、どんなに些細な処理でも慎重さを欠かさないようになったと語ってくれました。

「やばいモデルができたと思ったんですよね。再現率80〜90%。これはいけるぞと。」

そう振り返ったのは、丸谷さん。誰にアプローチすれば効果的かを予測する“予兆モデル”を構築していたときのこと。序盤は極めて高い精度に手応えを感じていましたが、上司からのひと言がきっかけで状況は一変します。

「精度、高すぎないか?」という指摘。調べてみると、なんとモデルにリークが発生していたことが発覚。学習データ上で正解とするユーザーが、なぜか重複したレコードを発行してしまうシステム仕様となっており、それがモデルの特徴量として取り込まれてしまったのです。これにより、実際の精度よりも大幅に高く表示されてしまうという“罠”にはまりかけていたのでした。

リークを解消した後は、精度は70%ほどに落ち着き、クライアントのKPIと照らし合わせた上でようやく現実的な判断が可能に。「再現率が高すぎるときほど、データの裏側に目を向けるべきだと痛感しました」と語った丸谷さん。時系列だけでなく、データ基盤や記録仕様そのものがリークの温床になることもある──そんな学びを与えてくれる実例でした。

菅は、アンケートデータを扱った際に直面した“思わぬ落とし穴”について語りました。たとえば、「当てはまる〜当てはまらない」の5段階評価を用いたアンケートで、1問目は「当てはまる」が高得点、2問目は逆に「当てはまらない」が高得点……というように、設問ごとにスコアの向きを変える工夫が、アンケート設計ではよく行われます。これは、回答者が無意識に「全部3」とか「全部5」と機械的に選ばないようにするための配慮です。

しかし、分析時にその設計意図を知らずにスコア変換をしなかったことで、データは意図と真逆の傾向=逆相関を示し、結果がまったく読めない状態に。冷静に設計を確認してみて、ようやく原因に気づいたと言います。

「アンケートが集まったあとからでは、設計の意図が見えづらくて結果もボヤっとしてしまう。あれは本当に痛かったです。失敗というより、設計意図の把握がどれほど大事かに気づけたことが収穫でした」と語りました。

前処理はデータが届いてから始めるのではなく、設計段階から始まっていると実感させられる体験談でした。

キャリア初期に経験した前処理の失敗のひとつとして杉山さんが語ってくれたのは、回帰分析の符号ミスにまつわる実務エピソードです。

当時、売上に関するKPIを上げるには「この変数を増やすべきだ」と分析結果に基づいて提案したものの、後に前処理のミスに気づき、再分析した結果はまさかの真逆──「むしろ減らした方が良い」という結論だったそうです。

普通なら大きな問題になりかねない状況でしたが、幸いにも施策自体はもともとの仮説や現場の流れに沿って進んでいたため、結果としては事なきを得ました。とはいえ杉山さんにとってはこの経験が大きな教訓になったといいます。

「一つのミスで分析の方向性を180度変えてしまう。前処理って命かかってるんだ、と痛感した」とのこと。それ以来、どんなに些細な処理でも慎重さを欠かさないようになったと語ってくれました。

「やばいモデルができたと思ったんですよね。再現率80〜90%。これはいけるぞと。」

そう振り返ったのは、丸谷さん。誰にアプローチすれば効果的かを予測する“予兆モデル”を構築していたときのこと。序盤は極めて高い精度に手応えを感じていましたが、上司からのひと言がきっかけで状況は一変します。

「精度、高すぎないか?」という指摘。調べてみると、なんとモデルにリークが発生していたことが発覚。学習データ上で正解とするユーザーが、なぜか重複したレコードを発行してしまうシステム仕様となっており、それがモデルの特徴量として取り込まれてしまったのです。これにより、実際の精度よりも大幅に高く表示されてしまうという“罠”にはまりかけていたのでした。

リークを解消した後は、精度は70%ほどに落ち着き、クライアントのKPIと照らし合わせた上でようやく現実的な判断が可能に。「再現率が高すぎるときほど、データの裏側に目を向けるべきだと痛感しました」と語った丸谷さん。時系列だけでなく、データ基盤や記録仕様そのものがリークの温床になることもある──そんな学びを与えてくれる実例でした。

菅は、アンケートデータを扱った際に直面した“思わぬ落とし穴”について語りました。たとえば、「当てはまる〜当てはまらない」の5段階評価を用いたアンケートで、1問目は「当てはまる」が高得点、2問目は逆に「当てはまらない」が高得点……というように、設問ごとにスコアの向きを変える工夫が、アンケート設計ではよく行われます。これは、回答者が無意識に「全部3」とか「全部5」と機械的に選ばないようにするための配慮です。

しかし、分析時にその設計意図を知らずにスコア変換をしなかったことで、データは意図と真逆の傾向=逆相関を示し、結果がまったく読めない状態に。冷静に設計を確認してみて、ようやく原因に気づいたと言います。

「アンケートが集まったあとからでは、設計の意図が見えづらくて結果もボヤっとしてしまう。あれは本当に痛かったです。失敗というより、設計意図の把握がどれほど大事かに気づけたことが収穫でした」と語りました。

前処理はデータが届いてから始めるのではなく、設計段階から始まっていると実感させられる体験談でした。

◆ 前処理の「正しさ」、どう検証する?

視聴者から寄せられた問いに対し、登壇者からリアルな実践知が語られました。

「積み上げた前処理の正しさは、どのように検証していますか?」

杉山さんは

- 初めて触るテーブルは必ず人に聞き全件検証する

- PythonとSQLで同じ処理を2通り書いて突き合わせる

という徹底ぶりを披露。それでも「他人にはなかなかやってもらえない」「新人やインターンは、途中で“なぜこんなことを…”と心が折れそうになる」と、現場ならではの苦労も明かしてくれました。

菅からも、再現性を担保するために「異なるチーム・異なる言語でのクロス検証体制を整えた経験」を紹介。

「Pythonで楽にできる処理も、SQLでは職人芸になる」と語り、現場間でのギャップの難しさにも言及しました。

丸谷さんは「分布や中央値などを出して、クライアントの肌感覚と照らし合わせる」という、より実務に寄り添った視点から検証の工夫をシェア。「データドリブンではなくても、クライアントの経験と照合することで、違和感のある処理に気づける」と、ユーザーとの距離感を活かした検証アプローチを語ってくれました。

それぞれの立場や環境の違いを反映した検証方法は、まさに現場の前処理を象徴するトークとなりました。

◆ 現場で使える!日常業務の前処理テクニック

次に話題は、日々の業務で実践している「前処理の工夫」へと移ります。

「おすすめの前処理テクニックを教えてください!」

丸谷さんは、分析基盤への負荷を抑えるために、メモリ効率や処理スピードを意識した工夫を実践していると紹介。

- 不要なデータの絞り込み

- データ型の最適化(int64→int32など)

- 処理順や抽出方法の見直し

など、パフォーマンスとコストを意識した前処理を日常的に実践しているとのこと。現場で鍛えられたスキルとして自然と習慣になっており、こうした具体的な取り組みは、基盤チームとの円滑な連携にもつながっているそうです。

続いて、杉山さんが日々の前処理で最も大切にしているのは、データを「目で見る」ことを絶対にサボらないという姿勢。「スキルが上がってくると、つい『これは飛ばしても大丈夫かな』と思う処理が出てくる。でも、どんなに慣れても“目で見る作業”だけは削っちゃいけないと思ってます」と力強く語りました。

具体的には、数値やIDだけのデータでは濡れ(欠損)などの確認、テキストが含まれる場合には文字の揺れや異常値をチェック。さらには「生で見て初めて気づけることがある」として、ヒストグラムなどの可視化と併せて、データに触れながら前処理の方針を立てる時間を惜しまないそうです。

菅もこれに共感し、「この会社では目検(めけん)って呼んでます」と紹介。エンジニアの中には“目グレップ”と呼ぶ人もいるそうで、人間の目による観察が持つ重要性が、プロたちの共通認識であることがうかがえました。

生成AI時代、前処理とデータサイエンティストの未来は?

中盤では、生成AI時代の今後に関する話題に。

「時折、データサイエンティストの仕事の大半はAIで置き換え可能なのでは?データサイエンティストは要らなくなるのでは?」という問題意識を持つ人々がおられますが、これについてどう思われますか?

杉山さんは、「少なくとも20年は確実に残る」としたうえで、

「まだまだ“初めてパソコンを導入します”みたいな現場もあるんですよ。そうした環境でデータを整えて最初の分析を行う役割は、今後も変わらずに必要なはずです。」

一方で、「データサイエンティストという肩書きが今のようにキラキラした職業と捉えられているかはわからない」とも付け加え、職業の位置づけが変化していく可能性も示唆しました。

丸谷さんは「データサイエンティストとして仕事を残していきたい」という願いを率直に表明しつつ、生成AIがコーディングの効率化を助けてくれる時代だからこそ、設計や出力の判断といった、前後工程の重要性が増すと語ります。

「コードを書くところはAIに任せられる。でも、どういう設計をして、出てきた結果をどう読み解くか。そこは人間の判断が要る。楽できるけど、楽してはいけない。」

菅は、生成AI時代における人材像の二極化が進むと言及。

「一方では、数理モデルやエンジニアリングに長けた“プロ中のプロ”が必要とされる。もう一方では、AIでは拾えないようなノイズや欠損を見つける“目検の極み”のような人の仕事も残っていくのではないでしょうか。」

菅自身も、「生成AIを活用することで、今までできなかったコーディングやモデリングができるようになった」としつつ、それでも「なぜこの特徴量を選んだのか?を問う視点は、まだまだAIには足りない」と、人間の目の大切さを強調しました。

杉山さんは、「少なくとも20年は確実に残る」としたうえで、

「まだまだ“初めてパソコンを導入します”みたいな現場もあるんですよ。そうした環境でデータを整えて最初の分析を行う役割は、今後も変わらずに必要なはずです。」

一方で、「データサイエンティストという肩書きが今のようにキラキラした職業と捉えられているかはわからない」とも付け加え、職業の位置づけが変化していく可能性も示唆しました。

丸谷さんは「データサイエンティストとして仕事を残していきたい」という願いを率直に表明しつつ、生成AIがコーディングの効率化を助けてくれる時代だからこそ、設計や出力の判断といった、前後工程の重要性が増すと語ります。

「コードを書くところはAIに任せられる。でも、どういう設計をして、出てきた結果をどう読み解くか。そこは人間の判断が要る。楽できるけど、楽してはいけない。」

菅は、生成AI時代における人材像の二極化が進むと言及。

「一方では、数理モデルやエンジニアリングに長けた“プロ中のプロ”が必要とされる。もう一方では、AIでは拾えないようなノイズや欠損を見つける“目検の極み”のような人の仕事も残っていくのではないでしょうか。」

菅自身も、「生成AIを活用することで、今までできなかったコーディングやモデリングができるようになった」としつつ、それでも「なぜこの特徴量を選んだのか?を問う視点は、まだまだAIには足りない」と、人間の目の大切さを強調しました。

「コードを書く経験、とりわけハードコーディングはどこまで必要だと思いますか?」

杉山さんは開口一番に「もうAIにやってほしいくらいです(笑)」と率直な願望を語ります。しかし一方で、AI任せにするにはまだまだ懸念もあると続けました。

「今のAIはアラが多いので手放しでは使えない。とはいえ、それも過渡期だけの話だと思うので、大学だったら“まず自分で書け”って教えるけど、実務では迷いますよね。」

「今のAIはアラが多いので手放しでは使えない。とはいえ、それも過渡期だけの話だと思うので、大学だったら“まず自分で書け”って教えるけど、実務では迷いますよね。」

「僕は、ハードコーディングをやっておいたからこそ、今AIが出したコードもきちんと読めるようになっていると思っています。」

「僕は、ハードコーディングをやっておいたからこそ、今AIが出したコードもきちんと読めるようになっていると思っています。」

さらに、モデル選定に関する実例も紹介。「かつて、カテゴリカル変数をK-Meansでクラスタリングしようとしていた人がいたが、K-Meansは本来連続値を扱うアルゴリズムなので、明らかな選定ミスだった」と指摘。中身を知らないと、AIの出力すら正しく評価できないという本質的なリスクを示しました。

菅もこれに同意しつつ、「前処理には“見る力”が要る」と強調。「どんなにAIが発展しても、“このデータがなぜ入ってないのか?”に気づくためには人間の目と知識が不可欠」と語り、コーディングや手法を理解することの重要性に改めて強調しました。

話題の中では、杉山さんからGoogleのテキスト前処理ライブラリ「langextract」の紹介もありました。非構造化データの扱いにおいても、前処理が進化を続けていることが実感できるひと幕でした。

Q&A&クイズ|好き・嫌いな前処理タスクは?

イベント終盤には、ちょっとユニークなクイズ形式で「登壇者の好き・嫌いな前処理タスクは?」をテーマにひと盛り上がり。参加者の皆さんも一緒に考えながら楽しめる時間となりました。

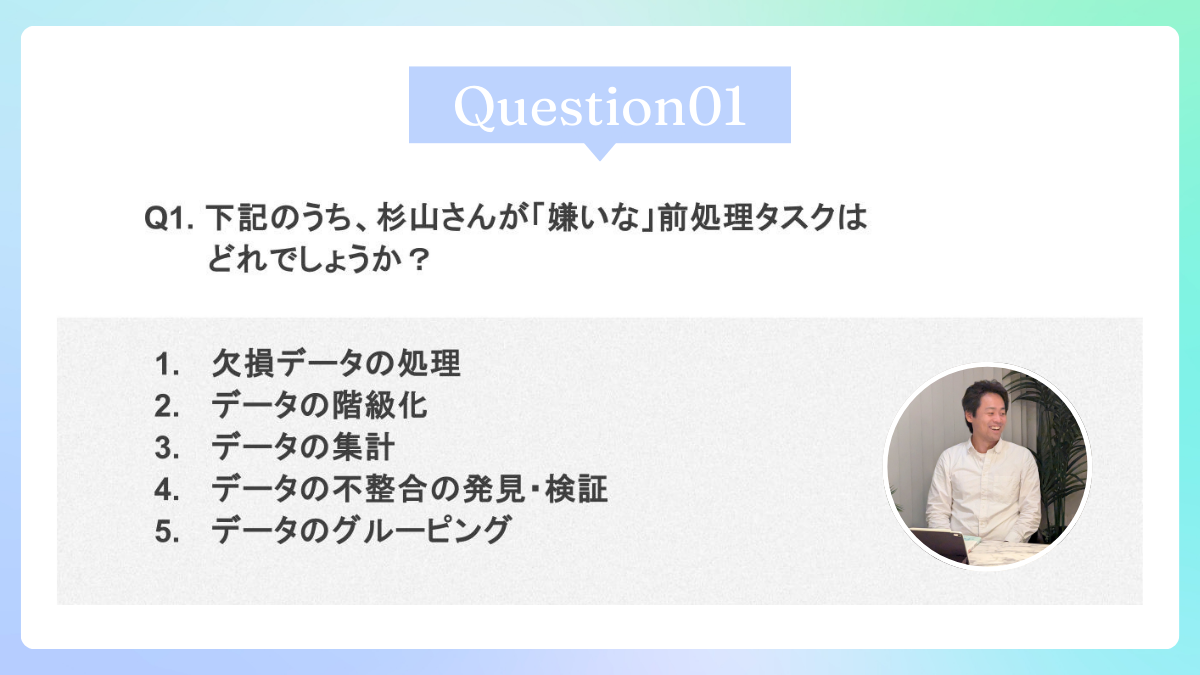

杉山さんが「嫌い」な前処理は?

答えは、4番 データの不整合の発見・検証でした。

「とても価値がある仕事だけど、全然楽しくない」と苦笑いで語る杉山さん。

不整合は発見・特定・修正すべてに膨大な手間がかかり、それでいて成果が評価されづらい。しかも本番データなので失敗も許されない…と、誰が悪いというより“構造的に楽しくならない作業”だと率直に語り、現場のリアルを感じさせました。

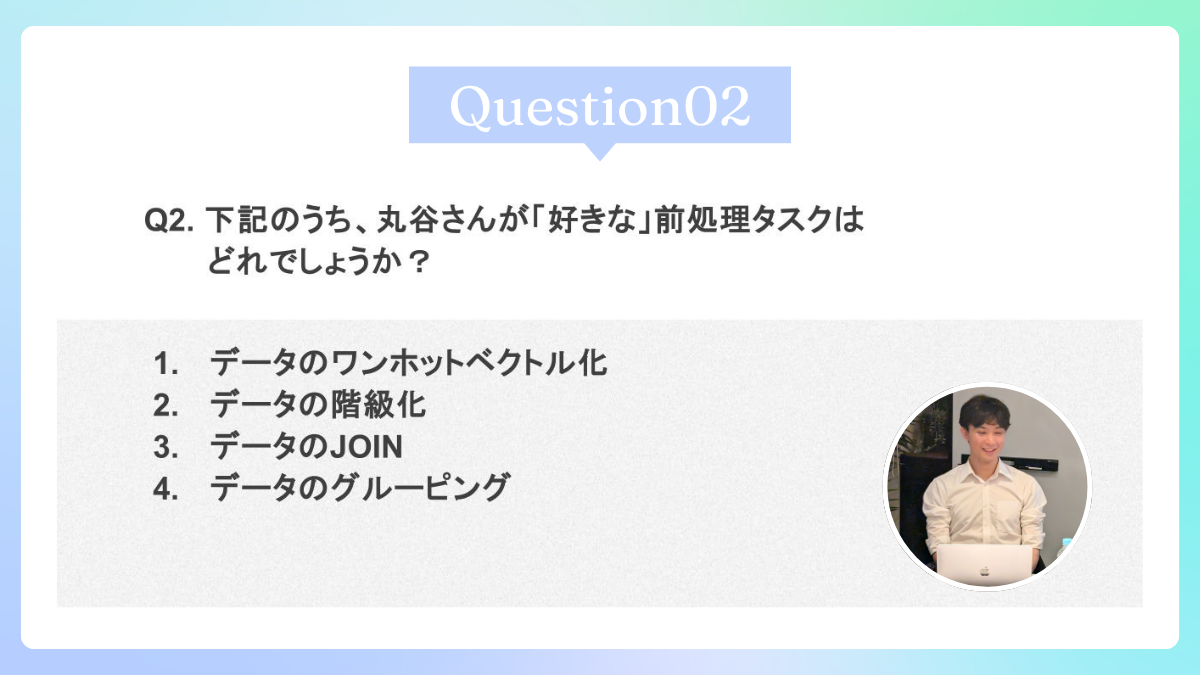

丸谷さんが「好き」な前処理は?

答えは、4番 データのグルーピングでした。

「グルーピングをしていくと、ぼやけていたデータの全体像が少しずつ鮮明になっていく。この“解像度が上がっていく感覚”がたまらないんです」と語る様子に、分析者の美学が垣間見えました。

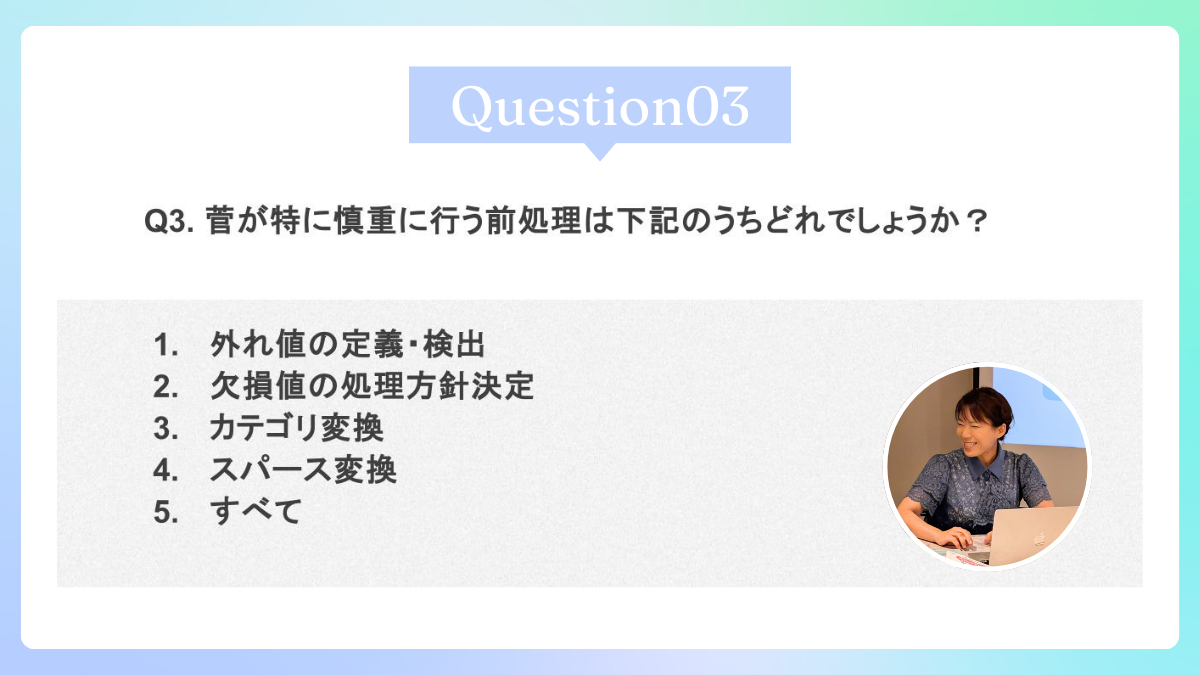

菅が「特に慎重に行う」前処理は?

答えは、1番 データの不整合チェックでした。

「外れ値こそ観測を」という言葉を師から叩き込まれてきたという菅は、極端な値をノイズとして除外する前に、「そこに知見の種が隠れているかもしれない」と一度立ち止まるそうです。たとえば、1人で毎日10回以上買い物している異常値の裏には、業者による大量購入といった実態が隠れていることも。「外れ値に宝物が隠されているかも」という視点が印象的でした。

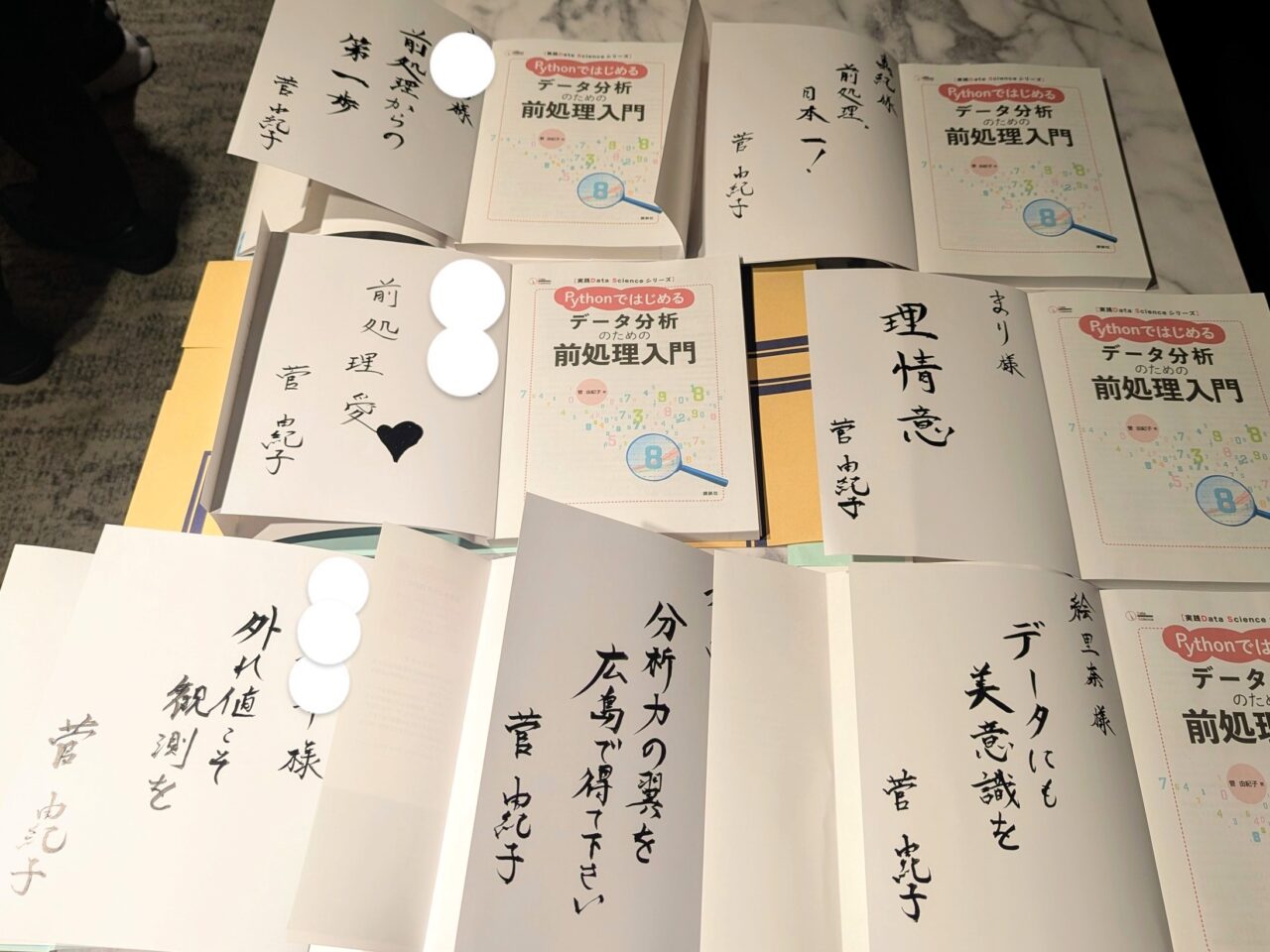

登壇者からのメッセージ

セッションの締めくくりに、登壇者3名から参加者へのメッセージが贈られました。

杉山 聡さん(株式会社アトラエ)

「前処理は最初に学ぶし、一番地味で大変。でもミスをすると致命的で、取り返しがつかない。だからこそプロの技が生きる場所なんです。この本には、生成モデルでのサンプル作成など、他にはあまり載っていない実践的な内容も盛り込まれています。読んで学びゼロということは絶対にありません。ぜひ手にとって、活用してみてください。」

丸谷 優太さん(AKKODiSコンサルティング)

「前処理はデータ分析の基礎の基礎。生成AIで効率化できる部分もありますが、手を抜いてはいけない部分はしっかり取り組む必要があります。私自身まだ若手で、日々“もしかしてミスしているかも”と不安になることもありますが、皆さんと一緒に挑戦しながら成長していけたらと思います。」

菅 由紀子(株式会社Rejoui/著者)

「まさか“前処理”をテーマに本を書く日が来るとは思ってもみませんでした。師からいただいた『前処理なくして分析なし』という言葉は、私にとって金言です。生成AIが進歩すれば、前処理の多くは不要になるかもしれません。でも、わずかなノイズが分析結果を左右するという事実は変わらないはず。その気づきを持つ人が一人でも増えればと思い、この本を書きました。今日ご参加いただいた皆さん、そして一緒に登壇してくれた仲間に心から感謝しています。書籍を広めていただき、ぜひ周りの方々にも活用していただければ嬉しいです。」

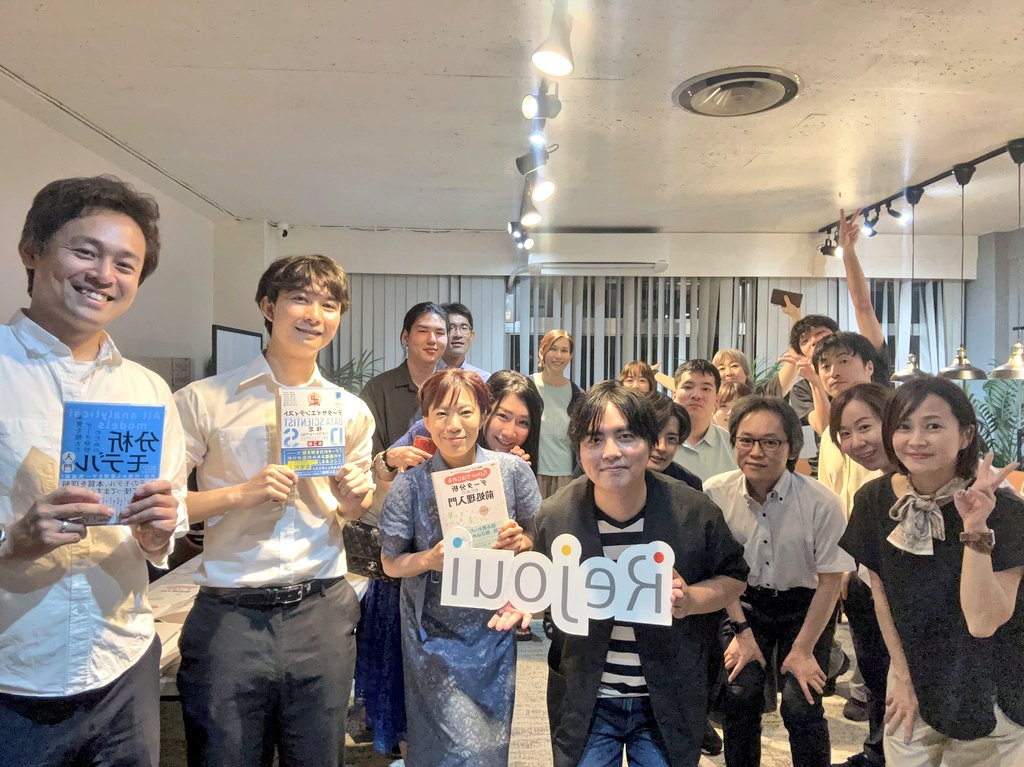

イベント後は会場参加者の交流タイムも設けられ、終始和やかな雰囲気でした。参加者の皆さんからは、「リアルな失敗談が聞けて参考になった」「前処理の奥深さを改めて感じた」といった声を多数いただき、著者をはじめ、スタッフ一同大きな励みとなりました。ご参加くださった皆さま、誠にありがとうございました!

書籍紹介ページ